| Die Analytische Gruppe von Azvision.az |

Waffe des neuen Jahrhunderts | Long Read// Wenn die Entwicklung Künstlicher Intelligenz nicht gesetzlich geregelt ist, kann das zu großen Problemen führen |

|

Die Menschheit hat ein sehr paradoxes Verhältnis zur Künstlichen Intelligenz: Einerseits reden alle darüber, kommen mehrmals am Tag mit ihr in Kontakt, diskutieren über ihre Auswirkungen auf unser Leben, andererseits haben die meisten immer noch keine klare Vorstellung davon. In diesem Sinne lässt sich Künstliche Intelligenz mit Elektrizität vergleichen: Als Elektrizität in unser Leben Einzug hielt, lehnten viele Menschen sie ab und hielten sie für schädlich. Derzeit ist Strom aus unserem Leben nicht mehr wegzudenken, doch die meisten Menschen wissen immer noch nicht, was Strom ist und wie er funktioniert. Da es keine klare Vorstellung davon gibt, was genau sie ist, sind Diskussionen über Künstliche Intelligenz meist fehlgeleitet. Wir wissen immer noch nicht: „Ist KI gefährlich oder nicht?“, „Ist KI Freund oder Feind?“ Wir setzen das Gespräch fort. Es ist jedoch an der Zeit, ganz andere Fragen zur Künstlichen Intelligenz zu stellen und Antworten darauf zu suchen. Was denkt oder nicht denkt sie? Um die richtigen Fragen zu stellen und die richtigen Antworten zu finden, muss man lernen, einen realistischen, praktischen Ansatz zu verfolgen und die Mythen rund um die Künstliche Intelligenz aufzuklären. Denn die Vorstellungen der meisten Menschen über KI wurden durch den Einfluss von Filmen und Kunstwerken geprägt. Und sie neigen normalerweise dazu, die Menschheit zu erschrecken und ein apokalyptisches Szenario zu schaffen. Man kann sagen, dass die wunderbare Zukunft, die mit Hilfe Künstlicher Intelligenz geschaffen wurde, in keinem Werk erwähnt wird. Das literarische Denken hat eine dystopische Haltung eingenommen und stellt Künstliche Intelligenz nur als böse und als Bedrohung dar. Auch die Vorgehensweise mancher Wissenschaftler und Experten verstärkt die literarische Angst. So war beispielsweise der berühmte Astrophysiker Stephen Hawking davon überzeugt, dass Künstliche Intelligenz zur Zerstörung der Menschheit führen wird. Im Jahr 2023 appellierten die Führungskräfte von 150 Unternehmen, darunter Elon Musk, Steve Wozniak und Bill Gates, sowie mehr als 600 Wissenschaftler an die Regierungen aller Länder und internationalen Institutionen und forderten, die Forschung im Bereich der KI einzustellen. Dieser Appell war, gelinde gesagt, äußerst seltsam. Um zu verstehen, warum, müssen wir uns zunächst die Klassifizierung von KI ansehen. KI-Spezialist Umid Suleymanov erklärte, dass Künstliche Intelligenz in drei Teile unterteilt wird: Schwache (schmale), starke (breite) und superkünstliche Intelligenz. Schwache (schmale) KI dient dazu, eine Aufgabe in einem separaten Bereich auszuführen – zum Beispiel Schach spielen, fotografieren, Text, Ton, Video erzeugen, Auto fahren. Alle Arbeitsmodelle, die wir heute haben, sind Beispiele für schwache (enge) Künstliche Intelligenz. Sie denken nicht wie Menschen, sie haben nicht die Mission, zu überleben oder mit Menschen zu konkurrieren. Daher können sie nicht eigenständig globale Probleme für die Menschheit schaffen.

|

|

| Umid Suleymanov: „Künstliche Intelligenz erlebt derzeit ihren zweiten Frühling“ |

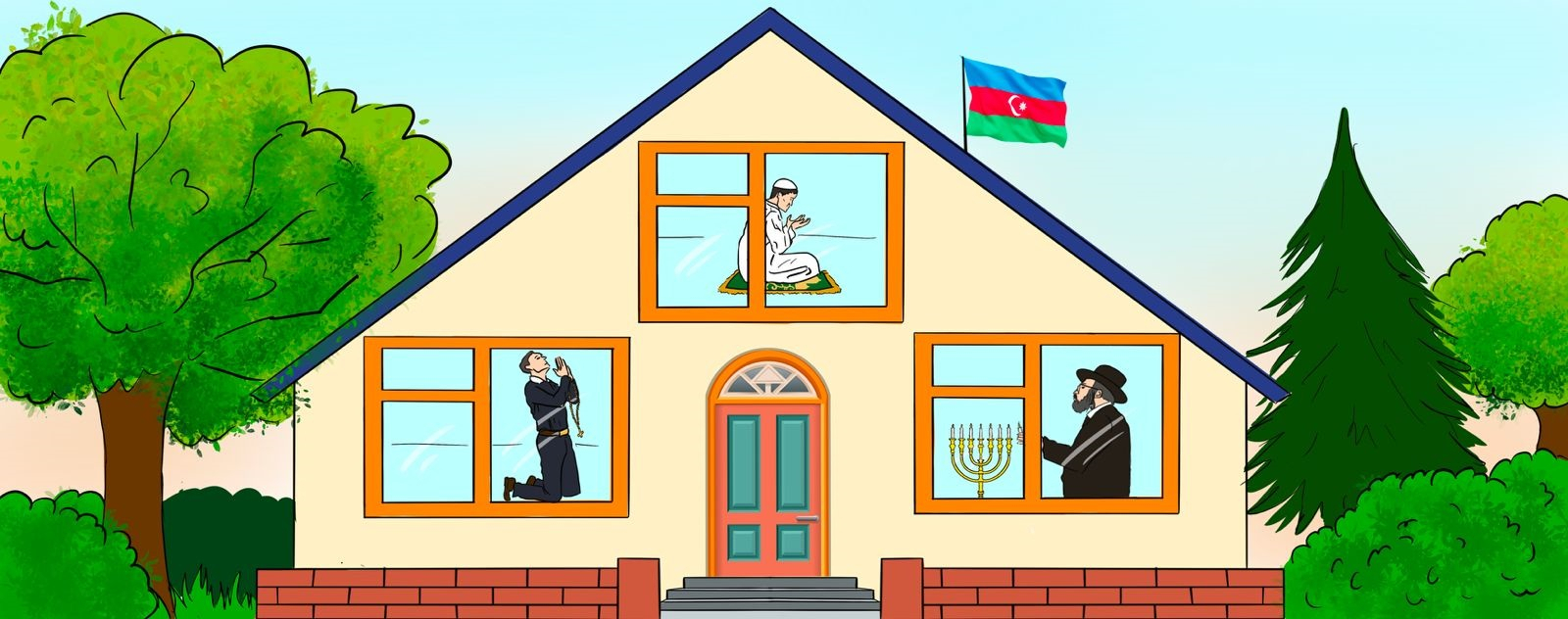

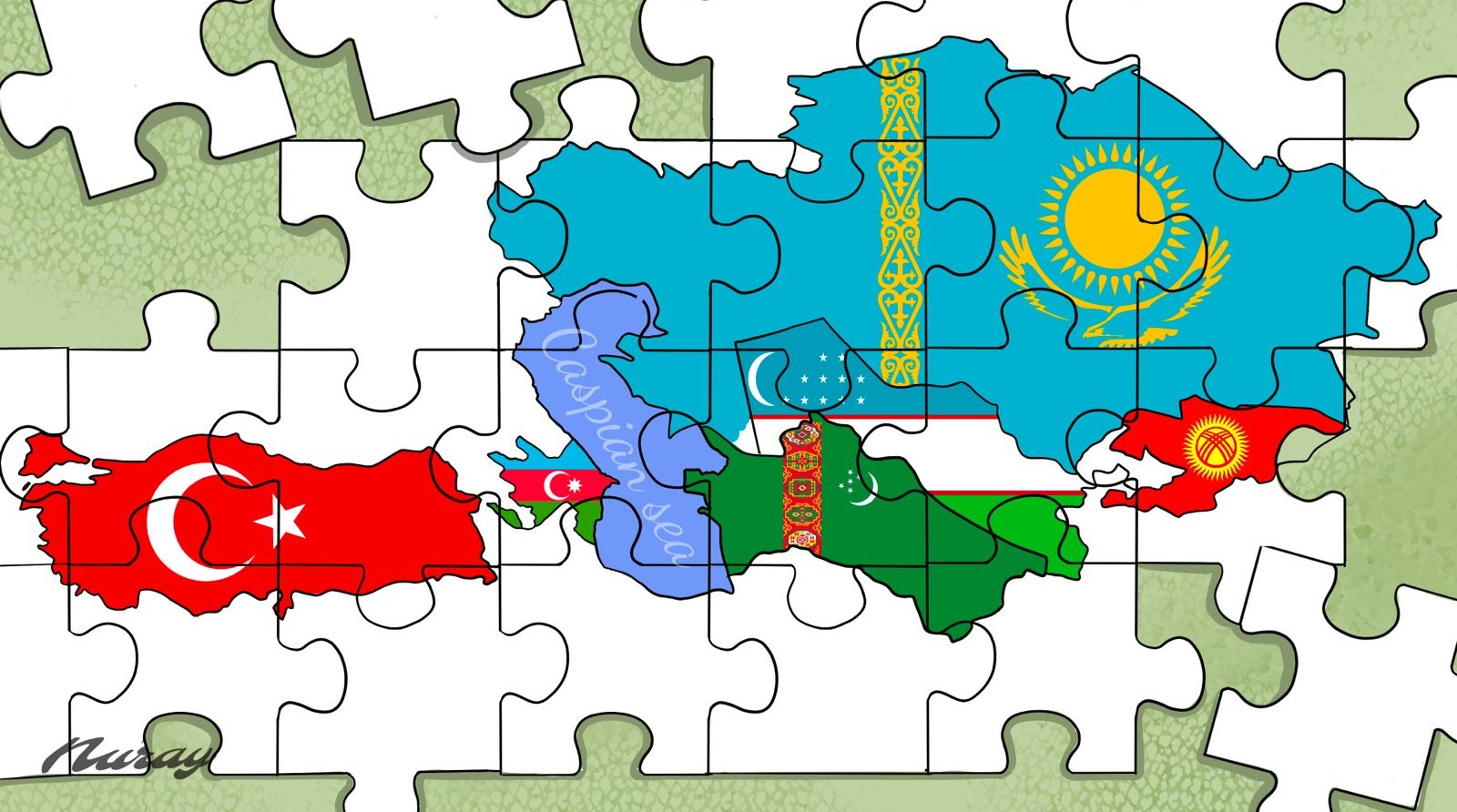

Tatsächlich ist es nicht wahr zu sagen, dass „Künstliche Intelligenz nicht wie Menschen denkt“, weil sie überhaupt nicht denkt. „ChatGPT“ und ähnliche neuronale Netze basieren auf einem statistischen System namens „Großes Sprachmodell" (Large Language Model). Dieses Modell verarbeitet große Textmengen und bestimmt, welches Wort in welchem Kontext nach welchem Wort stehen soll. Das interne Bewertungssystem des Modells weist erfolgreichen Optionen eine hohe Bewertung und erfolglosen Optionen eine niedrige Bewertung zu. Somit werden erfolgreiche Antworten ausgewählt. Mit anderen Worten: LLM ist ein Tool zur kreativen Generierung, das auf statistischen Analysen basiert. Deshalb begann im Jahr 2010 – nach der Stufe „Web 2.0“ – der sogenannte „Zweite Frühling der Künstlichen Intelligenz“. Denn zu dieser Zeit erstellten Nutzer selbst aktiv Inhalte im Internet und es entstand eine Datenbank, die von KI verarbeitet werden konnte. Was geht tief im Inneren vor? Es ist wichtig, zwischen Intelligenz und Bewusstsein zu unterscheiden. Das Ich-Gefühl und das Selbstbewusstsein gehören zum Bewusstsein, und der Intellekt ist lediglich ein Werkzeug. Tatsache ist, dass wir jetzt zum ersten Mal Intelligenz sehen, die über das Bewusstsein hinausgeht. Da es schwierig ist, sich menschliche Intelligenz außerhalb des Bewusstseins vorzustellen, ist es möglich, die Ängste vor Künstlicher Intelligenz zu verstehen – wir denken, dass es auf der anderen Seite jemanden gibt, der so bewusst ist wie wir. Aber das ist nicht so. Aktuelle Technologien und vor allem Methoden erlauben es nicht, starke (umfangreiche) KI zu schaffen. Bedingungen für Schreckensszenarien können entstehen, wenn die sogenannte technologische Singularität eintritt, sich Technologien in einem beispiellosen Tempo weiterentwickeln und Prozesse außer Kontrolle geraten. Was wir derzeit „Künstliche Intelligenz“ nennen, ist eigentlich ein selbstlernendes neuronales Netzwerk. Dies nennt man „Deep Learning“. Man kann den Verlauf dieses Lernprozesses nicht kontrollieren. Sonst wäre es ein Algorithmus, keine Intelligenz. Intelligenz bedeutet, zu unvorhersehbaren Schlussfolgerungen zu gelangen und neue Optionen zu generieren. So wie ein Mensch die Prozesse, die in seinem Kopf ablaufen, nicht kontrollieren kann, ist die Art und Weise, wie KI lernt und Entscheidungen trifft, für uns eine „Black Box“. Aber um eine „gute“ KI zu schaffen, müssen wir uns selbst kontrollieren. Denn KI lernt auf Basis der von uns erstellten Datenbank. Wenn wir zum Beispiel KI mit Texten erziehen, die Rassismus fördern, wird sie rassistisch. Rennen der Zukunft In jedem Fall muss man sich damit abfinden und akzeptieren, dass die Entwicklung von KI unausweichlich geworden ist. Danach wird die Zukunft der Staaten direkt davon bestimmt, wie sie dieses Instrument nutzen. Wenn im Jahr 2023 die weltweiten Investitionen in Künstliche Intelligenz 154 Milliarden Dollar betrugen, werden sie im Jahr 2026 300 Milliarden Dollar erreichen. Nach Prognosen des Beratungsunternehmens „International Data Corporation“ wird KI der Weltwirtschaft im Jahr 2030 mehr als 15 Billionen Gewinne bescheren. Unternehmen und Nationen, die KI heute stärker nutzen, werden morgen erfolgreicher sein. Auf der Welt hat der Wettbewerb im Bereich KI begonnen, und es ist notwendig, hart zu arbeiten, um in diesem Wettbewerb nicht zu verlieren. Jede Nation sollte entsprechend ihren Anforderungen ihre eigene Künstliche Intelligenz bzw. LLM-Modelle entwickeln. Während des Gipfeltreffens der türkischen Staatsoberhäupter im Juli 2024 in Schuscha empfahl der Präsident Kasachstans, Qassym-Schomart Toqajew, die Schaffung eines großen Sprachmodells auf der Grundlage der gemeinsamen türkischen Sprache. Elvin Abbasov, Experte für Hochtechnologien und Künstliche Intelligenz, sagte in einem Interview mit AzVision.az, dass Aserbaidschan derzeit im Wettbewerb um Künstliche Intelligenz verliere. Auf diesem Gebiet sind wir bestenfalls Verbraucher. Wir haben kein eigenes KI-Modell. Einer der Gründe ist, dass verschiedene Fonds nur in echte Unternehmen investieren und nicht in innovative Ideen investieren wollen. Andererseits wird es, selbst wenn wir unser eigenes KI-Modell erstellen, keinen relevanten Inhalt in der aserbaidschanischen Sprache für seine Entwicklung geben: „Eigentlich kann heute jeder eine KI erstellen". Da es in Aserbaidschan keine Datenbank gibt, können KI-Modelle nicht verbessert werden. Um KI zu schaffen, muss es nützliche Inhalte geben, die wir „Big Data“ nennen. „Wikipedia“ hat 300.000 armenische Artikel und 150-200.000 Benutzer. Es gibt 200.000 Artikel und 300.000 Benutzer auf Aserbaidschanisch. Wir als Volk sollten versuchen, nützliche Inhalte zu erstellen. Keine Regierungsbehörde sollte dies tun. Manche Themen liegen in der Verantwortung der Gesellschaft.“ |

| Elvin Abbasov: „Wir verlieren im Wettlauf um Künstliche Intelligenz“ |

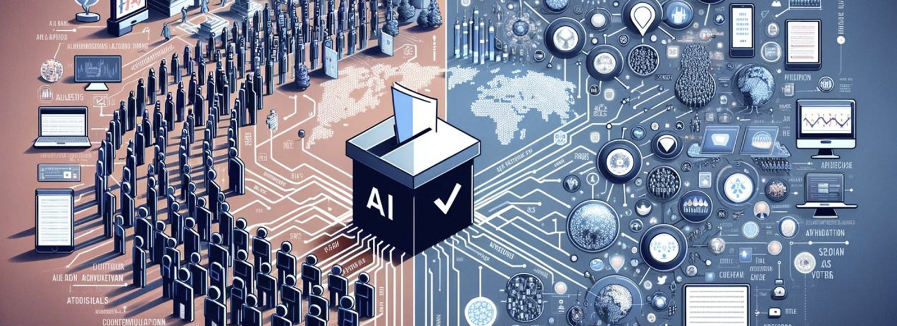

Doch das alles bedeutet nicht, dass die Entwicklung der Künstlichen Intelligenz nur eine schöne Zukunft verspricht und keine Gefahr darstellt. Es entstehen, aber das sind nicht die dargestellten Weltuntergangsszenarien, sondern eher praktische, konkrete Probleme. Zu den realen Problemen, die Künstliche Intelligenz verursacht, gehören beispielsweise die Verbreitung von Deepfakes, die deutlich einfachere Produktion gefälschter Inhalte und die Zunahme der Manipulationsmöglichkeiten der öffentlichen Meinung. Die Kombination der Fähigkeiten von KI und sozialen Netzwerken mit schädlichen Zwecken kann in Informationskriegen zu einer echten Atomwaffenwirkung führen. Neue Waffe der Informationskriegsführung Im Jahr 2008, im Wahlkampf von Barack Obama, begann mit der erstmaligen Nutzung sozialer Netzwerke eine neue Phase der Propaganda. Im Jahr 2012 profitierte Obamas Team dann zum ersten Mal in der Wahlgeschichte von der Hilfe Künstlicher Intelligenz. Es war KI, die festlegte, welche Themen der Präsidentschaftskandidat in seiner Rede in welchem Bundesstaat stärker hervorheben sollte. Späteren Schätzungen zufolge verschaffte diese Taktik Obama einen zusätzlichen Vorteil von 10–12 %. Es gibt niemanden, der nicht über den „Cambridge Analytica“-Skandal Bescheid weiß, der Donald Trump den Sieg bei der ersten Wahl bescherte. Dieses Unternehmen erwarb die Datenbank von etwa fünfzig Millionen Menschen, analysierte sie mithilfe von KI, entwickelte ihre Profile und stellte ihnen gezielte politische Werbung zur Verfügung. Einigen Behauptungen zufolge wurde die „Brexit“-Kampagne, die den Austritt Großbritanniens aus der Europäischen Union vorsah, gestartet, nachdem „Cambridge Analytica“ das Verhalten von Millionen Menschen im Internet analysiert hatte. Nigel Farage und Arron Banks, die Anführer der „Brexit“-Befürworter, standen in engem Kontakt mit der Führung von „Cambridge Analytica“. Wenn die Behauptungen wahr sind, kann „Brexit“ als erster Eingriff der Künstlichen Intelligenz in die Geopolitik angesehen werden. Während der israelischen Operation im Gazastreifen wurde Künstliche Intelligenz eingesetzt, um potenzielle Ziele zu lokalisieren. KI analysierte ihre Bewegungsrouten und gab an, in welchem Gebäude sie sich befinden könnten. Diese Taktik, die die Beseitigung der Führung der „Hamas“ in kurzer Zeit sicherstellt, kann als einer der ersten Einsätze von KI auf dem Schlachtfeld angesehen werden. Seit 2019 nutzt das britische Außenministerium offiziell Künstliche Intelligenz, um die Politik von Entwicklungsländern zu analysieren. Am 9. November 2023 gab das US-Außenministerium seine Strategie für den Einsatz Künstlicher Intelligenz bekannt. |

|

|

| Künstliche Intelligenzwerkzeuge können Pluralismus und Demokratie gefährden |

In Politik und Diplomatie hat KI ein breites Anwendungsspektrum: Entwicklung möglicher Konfliktszenarien, Vorhersage von Wahlergebnissen, Analyse großer Datenbanken, Untersuchung und Beeinflussung der öffentlichen Meinung in verschiedenen Ländern, Bestimmung wirtschaftlicher und sozialer Trends. Aber die Hauptanwendung liegt natürlich im Bereich der Information und Propaganda. Laut einer Studie der Universität Oxford versuchten im Jahr 2020 mindestens 81 Länder der Welt, die öffentliche Meinung mithilfe von Hochtechnologien zu manipulieren. Dazu gehören Tools wie Chatbots, Inhaltsalgorithmen und das Klonen menschlicher Stimmen. Im Jahr 2024 wurden diese Tools mit der bahnbrechenden Entwicklung neuronaler Netze weiter verbessert und neue hinzugefügt. Das Generieren hyperrealistischer Bilder, Töne und Videos, die nicht vom Original zu unterscheiden sind, war noch nie einfacher und zugänglicher. Darüber hinaus erstellt Künstliche Intelligenz nicht nur diese gefälschten Inhalte, sondern berechnet auch, wo, wem, wie und wann sie diese gezeigt werden. All dies geschieht mit einer solchen Geschwindigkeit, dass es schwerwiegende Folgen haben kann, bis Gegenmaßnahmen ergriffen werden. Dadurch entstehen sehr ernste neue Herausforderungen. LLM-Systeme sind bereits zum Hauptinstrument der Informationskriegsführung geworden. Sie sind in der Lage, große Mengen an Desinformation in verschiedenen Formen und Genres zu erzeugen. Deepfakes sind eine der schwerwiegendsten und gefährlichsten Formen der durch Künstliche Intelligenz geschaffenen Desinformation. Betrug in der Tiefe Deepfake – gefälschte Multimedia-Produkte, die praktisch nicht vom Original zu unterscheiden sind. Mit Hilfe eines Deepfakes können Sie eine berühmte Person, einen Politiker oder einen Staatsmann dazu bringen, etwas zu sagen, was er noch nie gesagt hat. Infolgedessen wird es sogar zu einer politischen und militärischen Krise kommen. Dafür gibt es viele Beispiele. Mitte 2018 war Gabuns Präsident Ali Bongo nach einem Schlaganfall mehrere Monate lang nicht in der Öffentlichkeit zu sehen. Als schließlich am Silvesterabend seine Ansprache an die Nation veröffentlicht wurde, erklärte die Opposition, dass das Video eine Fälschung sei und Bongo tatsächlich tot sei. Im Januar 2019 versuchten die Beamten einen Putsch. Allerdings war Bongo nicht tot und das Video war kein Deepfake. Im Vorfeld der Parlamentswahlen 2024 in Indien wurden Deepfakes häufig eingesetzt. Im Irak hat eine konservative Person, die gegen die Beteiligung von Frauen an der Politik ist, ein Deepfake-Video einer Kandidatin mit pornografischem Inhalt erstellt und verbreitet. Bald wird die Deepfake-Technologie einen solchen Entwicklungsstand erreichen, dass es schwierig werden wird, zu unterscheiden, ob die Person, die im Fernsehen spricht, echt oder eine virtuelle Kopie ist, die von KI erstellt wurde. Zu diesem Problem äußerte sich auch der Präsident von Aserbaidschan Ilham Aliyev. Auf eine Frage zur Künstlichen Intelligenz beim II. Globalen Medienforum in Schuscha antwortete das Staatsoberhaupt, dass das Thema derzeit eine neue Ebene erreiche. Von Zeit zu Zeit werden sogar eigene Deepfakes vorbereitet: „Anzeigen werden in meinem Namen mit Hilfe Künstlicher Intelligenz veröffentlicht, zum Beispiel hier Geld investieren, dort Geld investieren... Aber wenn sie so gehen, wird es andere Ankündigungen geben: Vielleicht erklären sie in meinem Namen jemandem den Krieg.“ Ich werde es glauben und einige Maßnahmen ergreifen können. |

| Ilham Aliyev: „Länder mit Atomwaffen können durch Künstliche Intelligenz manipuliert werden.“ |

Das Staatsoberhaupt betonte, dass es nicht nur um Aserbaidschan gehe: „Es gibt Länder mit Atomwaffen.“ Auch diese Länder können durch Künstliche Intelligenz manipuliert werden. Selbst auf Haushaltsebene können die Beziehungen, die Würde und der Ruf der Menschen irreparabel geschädigt werden. Persönlichkeiten des öffentlichen Lebens werden mit verschiedenen gefälschten Video-, Bild- und Audioinformationen beschuldigt. Ich denke, dass die Mediengemeinschaft den Politikern den Weg weisen sollte.“ Der kasachische Politikwissenschaftler Jaksylık Sabitov sagte gegenüber „AzVision“, dass eine gemeinsame Es besteht keine Notwendigkeit für die Armee Eine weitere Gefahr besteht darin, dass Unternehmen und Gruppen (Länder) mit einem starken KI-Modul in der Lage sein werden, sich im Online-Bereich leicht die Meinung und den ideologischen Hintergrund zu bilden, die sie benötigen. Wenn dafür gestern noch große „Trollfabriken“ nötig gewesen wären, dann jetzt kann nun Künstliche Intelligenz allen Streitigkeiten Farbe verleihen. Dies ist eine Bedrohung für den Pluralismus. Der „Big Tech“-Sektor und die Kräfte dahinter erhalten die Chance, die globale öffentliche Meinung zu prägen. Einer der bekanntesten Experten auf diesem Gebiet, Paul Timmers, Direktor für Digitale Gesellschaft, Vertrauen und Sicherheit der Europäischen Kommission für Kommunikationsnetze, schreibt, dass der Einfluss großer Technologieunternehmen auf die Geopolitik die Souveränität von Staaten untergräbt: „Man muss zugeben, dass Souveränität zu einem kontroversen Konzept wird, so wie Religion oder Kunst, wenn wir die Fähigkeit zur Kontrolle von Hochtechnologien als Machtkriterium akzeptieren.“ Auch Hikmet Hadschiyev, Assistent des Präsidenten Aserbaidschans und Leiter der Abteilung für außenpolitische Angelegenheiten der Präsidialverwaltung, ging beim II. Globalen Medienforum auf dieses Thema ein und erklärte, dass der Einsatz der Möglichkeiten der Künstlichen Intelligenz in sozialen Netzwerken zu unregelmäßigen Ergebnissen führen könne. Daher ist es an der Zeit, über die Entwicklung eines gesetzlichen Rahmens für Künstliche Intelligenz nachzudenken. Obwohl es private Initiativen zu diesem Thema gibt, gibt es auf internationaler Ebene keine ernsthaften Diskussionen.

Neue Waffe der Cyberkriegsführung Derzeit hat KI das Niveau erreicht, auf dem sie Computerprogramme schreiben kann. Dies wirft ernsthafte neue Fragen zur Cybersicherheit auf. Denn mit Hilfe von KI-Modellen ist es leicht, neue Viren zu erschaffen und groß angelegte Angriffe zu organisieren, wodurch neue ernsthafte Bedrohungen für die Cybersicherheit von Ländern entstehen. Ogtay Alakbarov, Chefspezialist des Instituts für Informationstechnologien, sagte in einem Interview mit AzVision.az, dass es viele Cyberangriffe auf unser Land gebe. Die Schwierigkeit auf dieser Ebene hängt auch mit der ständigen Weiterentwicklung und Aktualisierung des Cyberspace zusammen: „Heute bereiten wir uns beispielsweise darauf vor, den X-Angriff abzuwehren, und morgen nimmt diese Bedrohung bereits die Form von 2X an.“ Die Entwicklung von Technologien führt dazu, dass Cyber-Angriffe von Tag zu Tag zunehmen und komplexer werden. Es ist unmöglich zu wissen, woher die Angriffe kommen.“ |

| Ogtay Alakbarov: „Masse kann durch Künstliche Intelligenz leicht getäuscht werden“ |

Ein Cyberangriff auf die Datenbank einer Regierungsbehörde kann mehr Schaden anrichten als ein herkömmlicher Krieg. Daher sollten professionelle Experten für die Abwehr von Cyberangriffen geschult werden. Die Praxis zeige, so der Experte, dass ein gemeinsamer Kampf gegen Cybersicherheit effektiver sei. Aber es gibt ein Vertrauensproblem: Länder wollen ihre Erfahrungen nicht teilen, weil sie davon ausgehen, dass sie gegen sie verwendet werden könnten.

Die Konzentration von Hochtechnologien wie Künstlicher Intelligenz in wenigen Händen wird sowohl die Machtverhältnisse in der Welt verändern als auch die wirtschaftliche und soziale Ungleichheit verstärken. Denn die Länder, die in diesem Bereich vorankommen, werden dank KI einen starken Impuls in wissenschaftlicher und technischer Richtung erhalten. Dies wird sich bald auch im wirtschaftlichen und sozialen Bereich bemerkbar machen. Durch den Zugang zu Künstlicher Intelligenz entstehen neue Eliten, die möglicherweise die etablierten gesellschaftspolitischen Spielregeln ins Wanken bringen. So wie es im 20. Jahrhundert ein Wettrüsten zwischen den Großmächten der Welt gab, so findet auch heute der Wettlauf um Künstliche Intelligenz statt. Im Jahr 2021 veröffentlichte die US-amerikanische Nationale Sicherheitskommission für Künstliche Intelligenz einen Bericht, in dem es hieß, dass es notwendig sei, mit Verbündeten in diesem Bereich zusammenzuarbeiten, um zu verhindern, dass China sie überholt. China selbst hat ein System namens „Goldener Schild“ geschaffen, um sich vor westlichen KI-Eingriffen zu schützen. Der russische Präsident Wladimir Putin erklärte klar: „So wichtig waren die Atom- und Raketenprojekte der UdSSR in den 50er Jahren des letzten Jahrhunderts, so wichtig ist es für Russland auch, Künstliche Intelligenz zu entwickeln.“ Dadurch entsteht eine paradoxe Situation: Einerseits müssen die Länder der Welt ihre Kräfte bündeln, um den Gefahren vorzubeugen, die durch Künstliche Intelligenz entstehen können. Andererseits sind sie nicht mehr so sehr daran interessiert, Innovationen im Bereich der KI zu teilen, wie sie es einst waren, die Nukleartechnologie geheim zu halten. Am 21. März dieses Jahres war die Verabschiedung des Dokuments zur Regelung von KI durch die UN-Generalversammlung ein historisches Ereignis. Die von 123 Ländern auf Initiative der Vereinigten Staaten erstellte Erklärung „Nutzung der Fähigkeiten sicherer und zuverlässiger künstlicher Intelligenzsysteme für nachhaltige Entwicklung“ sah die Regelung der Anwendung von KI durch internationales Recht vor. In dem Dokument wurde betont, dass die Verwendung von KI ohne angemessene Sicherheitsmaßnahmen und internationale Rechtsnormen durchaus ernsthafte Risiken mit sich bringt. Solche Verhaltensweisen können die technologische Kluft zwischen Ländern vertiefen, Vorurteile und Diskriminierung verstärken, den Zugang zu Informationen einschränken und Menschenrechte und Freiheiten beeinträchtigen. |

|

|

| Die Europäische Union kann als erste Zone angesehen werden, in der der Einsatz Künstlicher Intelligenz gesetzlich geregelt ist |

In dem am 13. März vom Europäischen Parlament verabschiedeten Gesetz ist KI in zwei Teile unterteilt: „Verboten“ und „Hohes Risiko“. KIs, die in der Lage sind, menschliche Emotionen zu erkennen und Manipulationen vorzunehmen, gehören zur Kategorie „verboten“, da mit ihrer Hilfe menschliche Freiheiten eingeschränkt werden können. Was „Hochrisiko“-Technologien betrifft, müssen alle mithilfe von KI erstellten Fotos und Videos gesetzlich entsprechend gekennzeichnet werden. Damit kann die Europäische Union als erste Zone angesehen werden, in der der Einsatz Künstlicher Intelligenz gesetzlich geregelt ist. Allerdings gehört die Europäische Union nicht zu den Spitzenreitern im KI-Wettbewerb. Die führenden Länder haben es nicht eilig, entsprechende Gesetze zu verabschieden. Denn die Erfahrung der Europäischen Union hat gezeigt, dass solche Schritte den Investitionsfluss im IT-Bereich verringern. Konkurrierende Länder haben daran kein Interesse. Ergebnis Es besteht absolut keine Notwendigkeit, die Entwicklung der Künstlichen Intelligenz zu behindern. Tatsächlich ist es überhaupt nicht möglich. Länder und Völker, die KI blockieren, blockieren ihre eigene Entwicklung. Es ist wichtig, in diesem Rennen voranzukommen und eigene nationale LLM-Modelle zu entwickeln. In naher Zukunft werden KI-Systeme zu einem Faktor werden, der der Entwicklung von Ländern große Impulse verleiht. Wichtig ist aber auch, diesen Wettbewerb der KI durch internationale Normen und Mechanismen zu regulieren. Wie der aserbaidschanische Präsident Ilham Aliyev sagte, sollten Politiker ernste Entscheidungen treffen, um den Schaden zu begrenzen, den KI anrichten könne: „Ein solcher Mechanismus kann auf internationaler Ebene entwickelt werden.“ Dies wird unter keinen Umständen als Einschränkung der Meinungsfreiheit angesehen. Initiativen können auf UN-Ebene oder von den „Big 20“ vorgeschlagen werden. Wenn es gelingt, kann die Menschheit mithilfe Künstlicher Intelligenz ihre Probleme lösen und ihre Entwicklung beschleunigen. Andernfalls wird es ein so zusätzliches Problem bekommen, dass die Atom- und Klimakrise im Vergleich dazu wie ein Kinderspiel erscheint. |

Strategie für Staaten wichtig sei, um sich vor den schädlichen Auswirkungen von KI zu schützen. Eine kohärente Strategie in Richtung des gemeinsamen Kampfes der Regierungen gegen „Deepfake“ ist jedoch noch nicht definiert.

Strategie für Staaten wichtig sei, um sich vor den schädlichen Auswirkungen von KI zu schützen. Eine kohärente Strategie in Richtung des gemeinsamen Kampfes der Regierungen gegen „Deepfake“ ist jedoch noch nicht definiert. Der ehemalige stellvertretende Minister für Informationspolitik der Ukraine und Experte des Instituts für Post-Informationsgesellschaft, Dmytri Zolotukhin, sagte gegenüber AzVision.az, dass derzeit nur die Vereinigten Staaten über die gesetzliche Regulierung künstlicher Intelligenz diskutieren. Wenn der Einsatz dieses Tools auf einem transparenten und ethischen Mechanismus basiert, wird das Desinformationsphänomen selbst verschwinden. Aber Künstliche Intelligenz wird für böswilligere Zwecke eingesetzt. Diese schädlichen Aktivitäten werden hauptsächlich im sozialen Netzwerk ausgeübt.

Der ehemalige stellvertretende Minister für Informationspolitik der Ukraine und Experte des Instituts für Post-Informationsgesellschaft, Dmytri Zolotukhin, sagte gegenüber AzVision.az, dass derzeit nur die Vereinigten Staaten über die gesetzliche Regulierung künstlicher Intelligenz diskutieren. Wenn der Einsatz dieses Tools auf einem transparenten und ethischen Mechanismus basiert, wird das Desinformationsphänomen selbst verschwinden. Aber Künstliche Intelligenz wird für böswilligere Zwecke eingesetzt. Diese schädlichen Aktivitäten werden hauptsächlich im sozialen Netzwerk ausgeübt. Arman Abdrasilov, internationaler Experte auf dem Gebiet der IT- und Cybersicherheit, Mitglied der UN-Wirtschafts- und Sozialkommission für Asien und den Pazifik (ESCAP), betonte, dass es für die Länder der Organisation Türkischer Staaten (TDT) notwendig sei, im Rahmen des Kampfes gegen „Deepfake“ einheitliche Standards zu entwickeln.

Arman Abdrasilov, internationaler Experte auf dem Gebiet der IT- und Cybersicherheit, Mitglied der UN-Wirtschafts- und Sozialkommission für Asien und den Pazifik (ESCAP), betonte, dass es für die Länder der Organisation Türkischer Staaten (TDT) notwendig sei, im Rahmen des Kampfes gegen „Deepfake“ einheitliche Standards zu entwickeln.